Проверка файла robots.txt: 5 бесплатных сервисов

Файл robots.txt знаком всем SEO-специалистам, ведь он оказывает большое влияние на ранжирование веб-ресурса в поисковых системах. Он дает поисковым роботам рекомендации о том, какие разделы и веб-страницы сайта индексировать необходимо, а какие не должны попасть в результаты поисковой выдачи. Кроме того, если сайт переезжает на новый домен, файл помогает ему не потерять трафик и результаты поисковой оптимизации. Поисковые системы называют такие правила директивами, однако, сами себе противореча, могут проигнорировать их. Ошибки при составлении файла приводят к некорректной индексации сайта и отсутствию возможности вывести сайт в ТОП-10 поисковых результатов. Начинающим SEO-специалистам не повредит помощь сервисов, которые могут проверить robots.txt и дать рекомендации по его улучшению. Обзор пяти бесплатных сервисов по чек-апу robots.txt — в статье.

Сервисы для анализа файла robots.txt онлайн

- Анализ robots.txt в Яндекс.Вебмастер.

- Инструмент от Google Search Console.

- Проверка файла от Websiteplanet.

- Сервис Tools.discript.ru.

- Проверка от Pixelplus.

Изображение от pch.vector на Freepik.

Не все страницы сайта содержат оригинальный, релевантный и качественный контент. Некоторые и вовсе содержат конфиденциальные данные и не должны попадать в открытый доступ. Если владелец сайта знает о всех недостатках и особенностях веб-ресурса, он может повлиять на его индексирование. Разместив в корневом каталоге сайта файл robots.txt, можно не беспокоиться о том, что поисковые алгоритмы будут оценивать каждую веб-страницу. Изучив ваши рекомендации, они посетят только те, в качестве контента которых вы уверены.

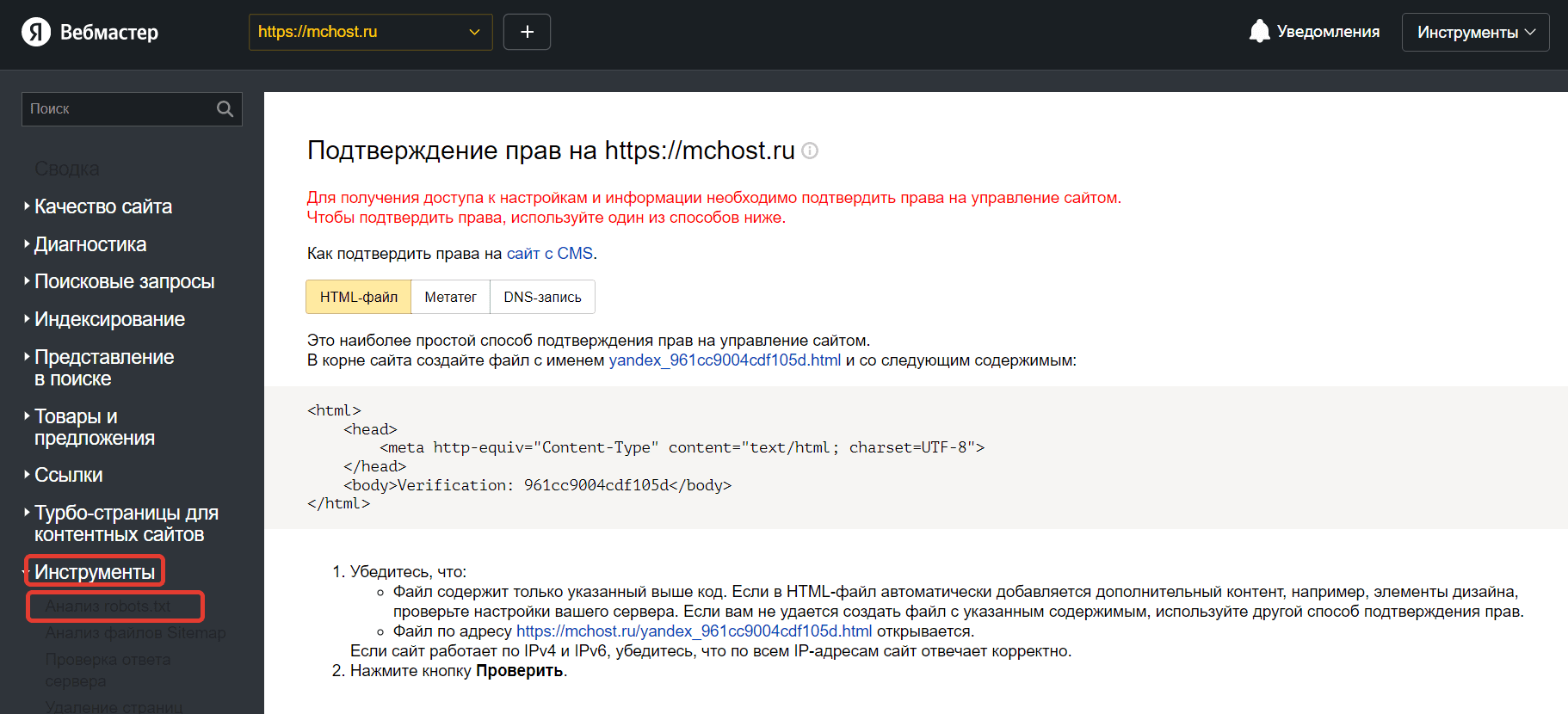

№1. Анализ robots.txt в Яндекс.Вебмастер

Яндекс.Вебмастер — инструмент от главной поисковой системы Рунета. Его использование является абсолютно свободным и бесплатным. Однако вам придется подтвердить, что вы имеете права на управление сайтом. Добавив сайт в панель управления Вебмастера и пройдя аутентификацию в качестве владельца веб-ресурса, вы можете перейти к работе с инструментами для анализа SEO-показателей сайта и продвижения в поисковой системе Яндекс.

Алгоритм проверки robots.txt с помощью валидатора Яндекс:

- В левом меню найдите раздел «Инструменты», выберете инструемент «Анализ robots.txt».

- Содержимое файла должно появиться в поле проверки автоматически. При отсутствии результата скопируйте код и вставьте его в поле самостоятельно. Нажмите на кнопку проверки.

- Результаты анализа появился ниже. При наличии ошибок валидатор выделит их цветом и оставит комментарий.

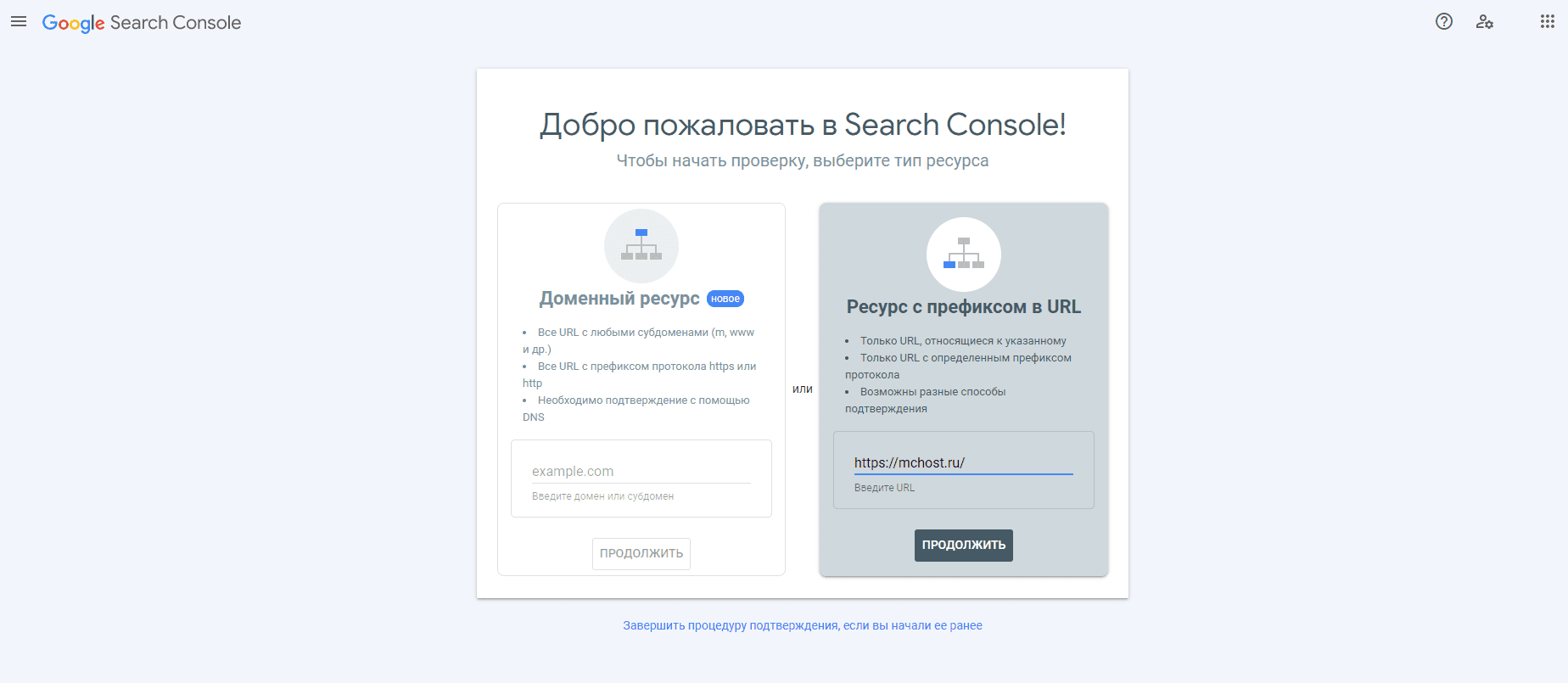

№2. Инструмент от Google Search Console

Google Search Console — простой инструмент для проверки файла robots.txt от Google. Он также потребует от вас подтверждения прав на владение веб-ресурсом.

После того как вы пройдете данную формальную процедуру, можно будет переходить к работу с файлом с директивами.

- Откройте страницу «Инструменты проверки».

- Если автоматически открылся файл с устаревшей версией robots.txt, отправьте актуальный файл и следуйте инструкциям сервиса.

- Обновите страницу и подождите появления директивов. Ошибки будут перечислены под кодом.

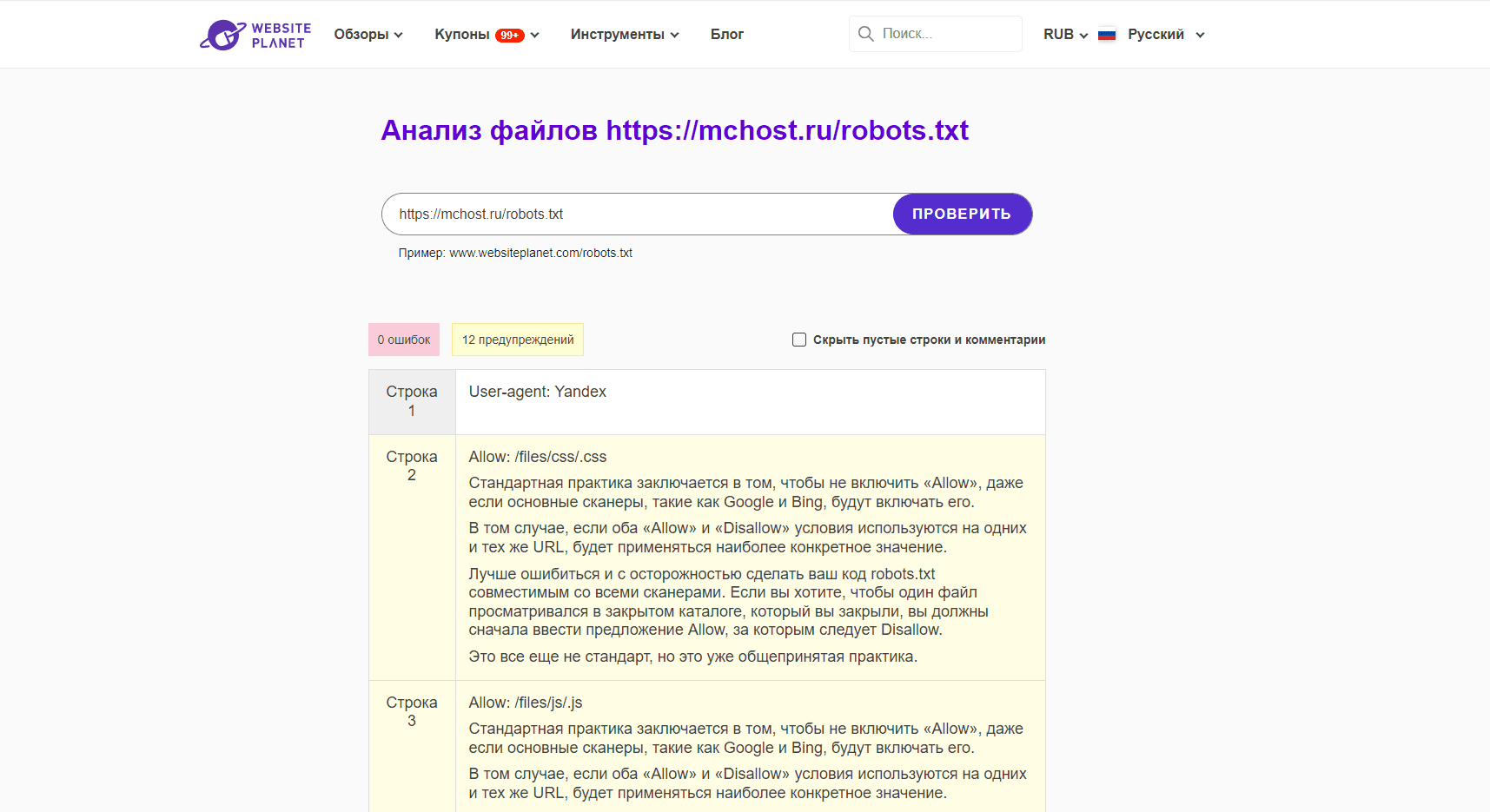

№3. Проверка файла от Websiteplanet

Сервис работает быстро. Он не требует от пользователей подтверждения прав на владение сайтом. Чтобы запустить проверку файла с директивами, достаточно указать место его расположения, например, у нас это https://mchost.ru/robots.txt. Инструмент показывает не только ошибки, но и предупреждения. Каждый недочет сопровождается развернутым комментарием.

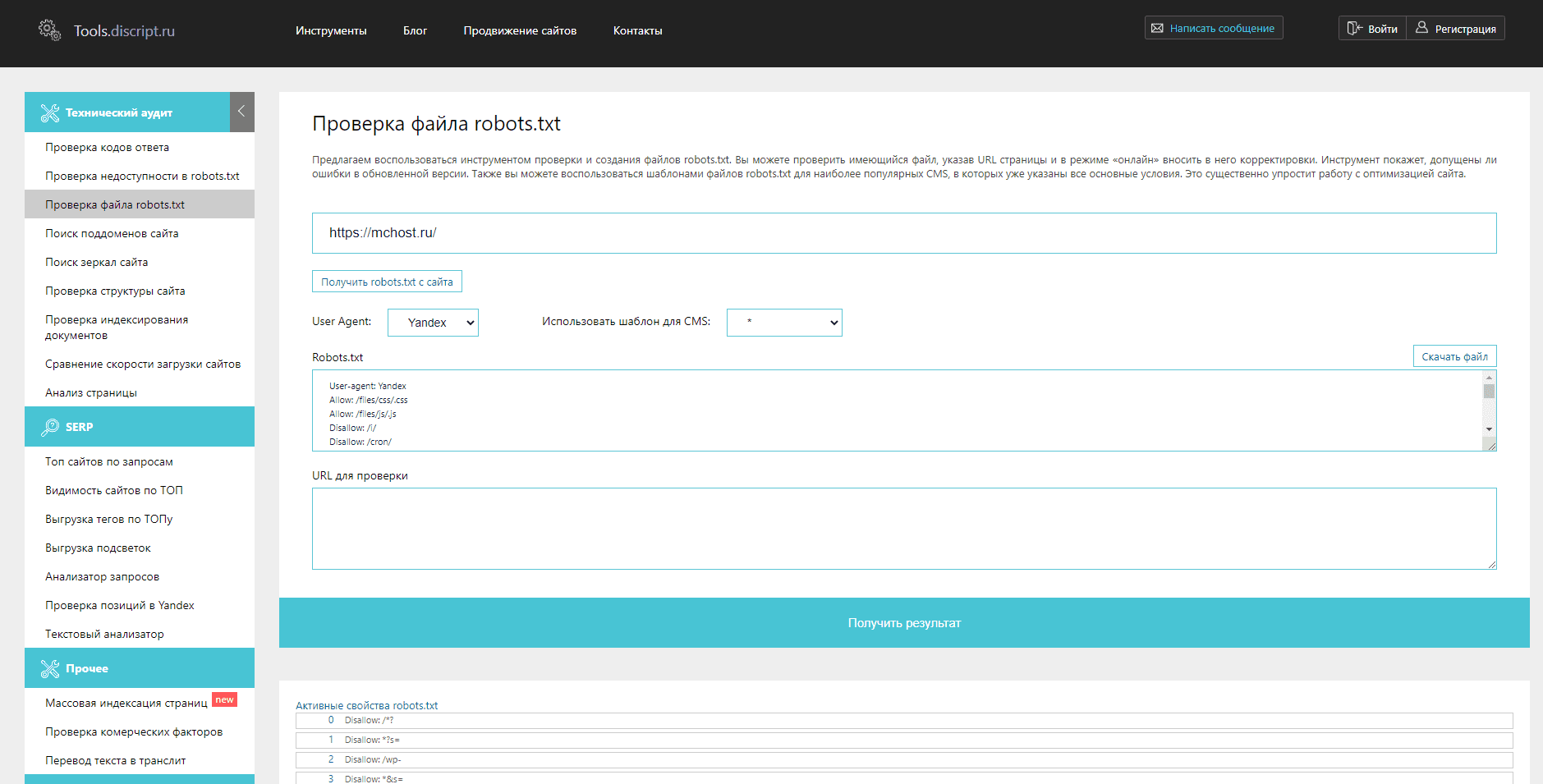

№4. Сервис Tools.discript.ru

Инструмент позволяет проверять robots.txt на ошибки, редактировать его в режиме онлайн, оптимизировать под CMS сайта и конкретного поискового агента, создавать новый файл и скачивать готовую версию.

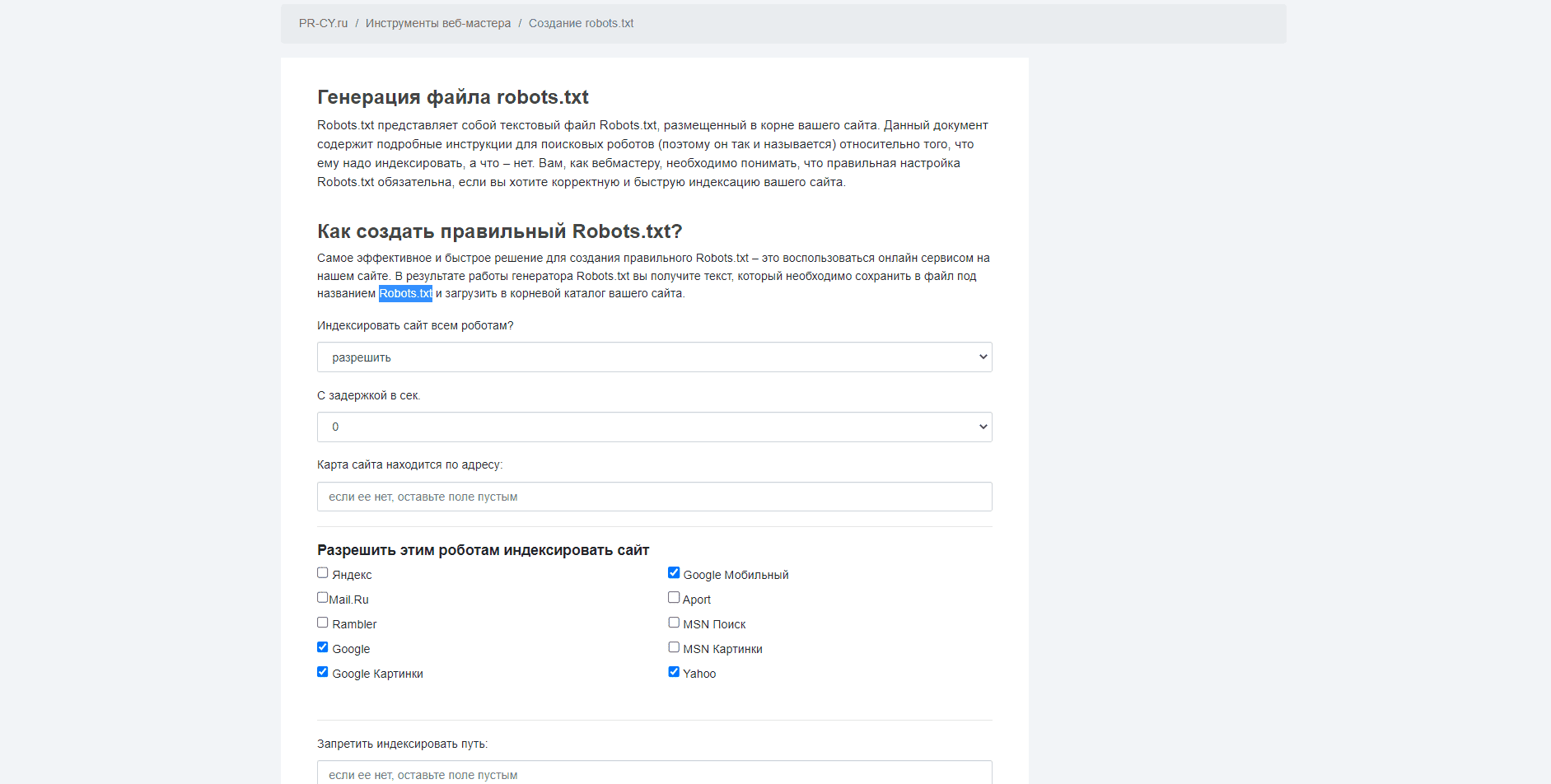

№5. Проверка от PR-CY

Сервис предлагает бесплатное создание файла с директивами для поисковых систем. Пользователю нужно настроить параметры будущего robots.txt, указав какие поисковые системы смогут его индексировать, путь к карте сайта, страницы, которые индексировать нельзя. В результате сервис формирует текст robots.txt, который необходимо сохранить в файле под одноименным названием и добавить в корневой каталог сайта.

Заключение

От правильной записи директив в файле robots.txt зависит успех продвижения сайта в сети. Начинающие SEO-специалисты могут воспользоваться онлайн-сервисами, чтобы проверить свой файл, перед его размещением в корневом каталоге.

Оцените статью